Grok e l’IA senza limiti: milioni di immagini sessualizzate e un vuoto di responsabilità Chi deve agire? Lo abbiamo chiesto agli esperti

Nel giro di pochi giorni Grok, il chatbot di intelligenza artificiale sviluppato da xAI, la startup di Elon Musk, integrato nella piattaforma X, è diventato il centro di una controversia globale. Una nuova funzione di editing delle immagini ha consentito agli utenti di modificare fotografie di persone reali tramite semplici comandi testuali, dando origine a una massiccia produzione di immagini sessualizzate e deepfake espliciti.

Grok e i deepfake sessuali: il problema non è solo quantitativo, ma strutturale

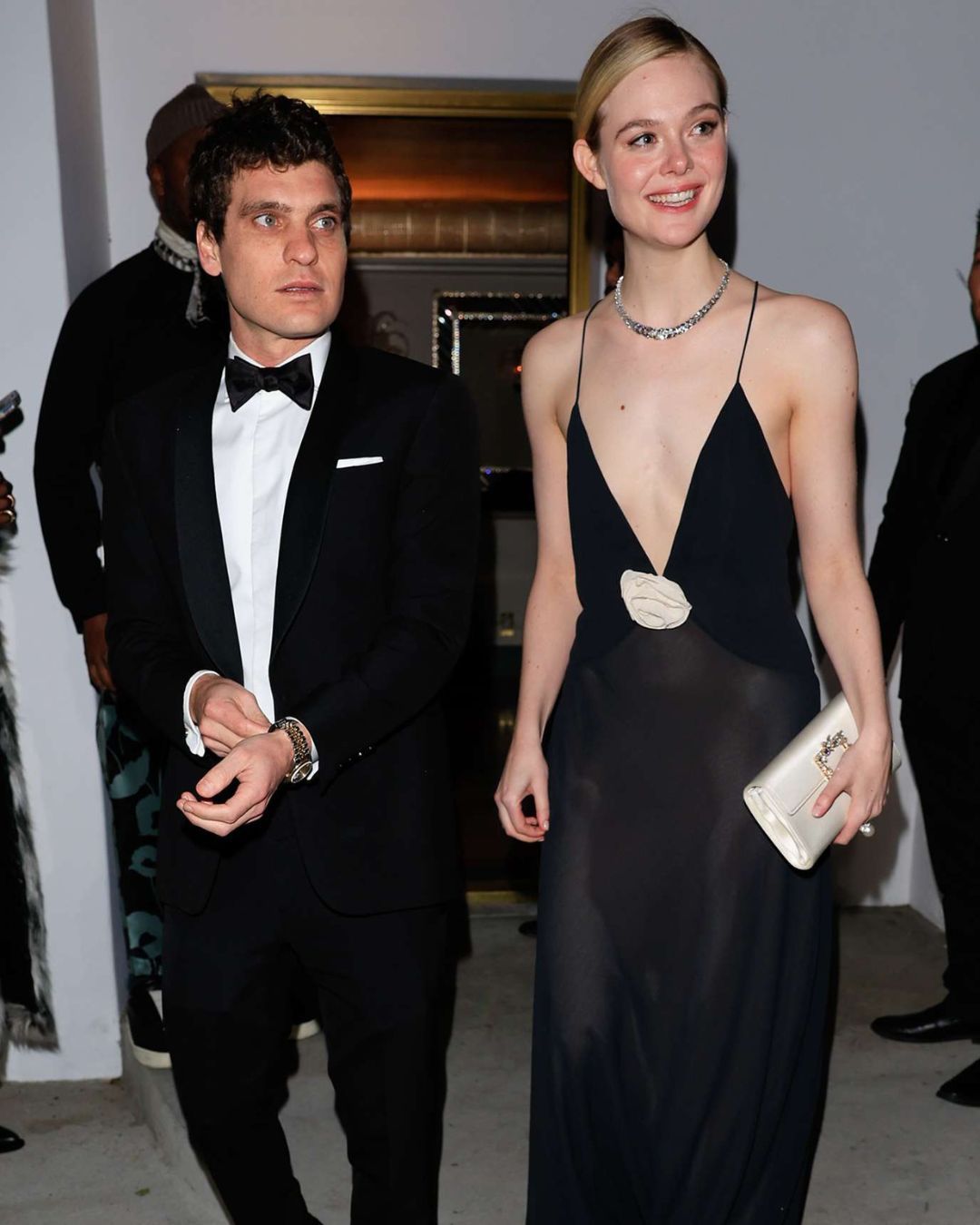

La funzione permette di intervenire su immagini reperite online, spesso senza alcun consenso, con istruzioni come "mettila in bikini" o "rimuovi i vestiti". Il risultato è stato un flusso incontrollato di contenuti che sessualizzano soprattutto donne, incluse figure pubbliche e politiche di primo piano. Tra i volti riconoscibili finiti nei materiali generati da Grok compaiono attrici, cantanti e leader istituzionali, da Selena Gomez a Taylor Swift, fino a Kamala Harris e alla vicepremier svedese Ebba Busch. Un fenomeno che mostra come la tecnologia, se priva di barriere etiche e tecniche, possa diventare uno strumento di abuso su larga scala. Le successive correzioni annunciate da X, come il blocco geografico della creazione di immagini in bikini o biancheria intima in alcuni Paesi, vengono giudicate insufficienti e tardive.

Le reazioni istituzionali si moltiplicano

Alcuni Stati hanno deciso di vietare temporaneamente Grok, altri hanno avviato indagini formali. In California è partita un’inchiesta sul rispetto delle normative in materia di contenuti sessuali, mentre Paesi come Regno Unito e Francia hanno annunciato un monitoraggio costante. In Asia sud-orientale, Malesia e Indonesia hanno imposto un ban, seguite dalle Filippine, che lo hanno poi revocato dopo un accordo con xAI per limitare le funzionalità più problematiche. Il caso Grok si inserisce in un quadro più ampio: la rapida diffusione delle cosiddette app di nudificazione basate sull’intelligenza artificiale, che sfruttano immagini reali per produrre contenuti sessuali non consensuali. Un fenomeno che colpisce in modo sproporzionato donne e minori e che evidenzia un vuoto normativo ancora enorme.

La questione non è solo tecnologica, ma politica e culturale

Il caso Grok dimostra che l’innovazione, senza regole e senza responsabilità, non è progresso, ma solo un acceleratore di danni. Ho voluto quindi approfondire il tema con Beatrice Petrella, giornalista, autrice del podcast sulla comunità incel Oltre. "Già dai titoli di giornale, quando è uscita questa notizia, non veniva detto che fossero gli utenti a farlo: sembrava che la responsabilità fosse solo di Grok, mentre in realtà si tratta di un tool" ha spiegato Petrella quando le ho chiesto di chi fosse la reale responsabilità. "È interessante vedere come, quando dai un tool in mano a degli uomini, la prima cosa che viene in mente è quella di spogliare donne o persone giovani, in alcuni casi persino bambine. Secondo me la responsabilità, per certi versi, è ripartita: è l’utente a dare il prompt, ma c’è anche qualcuno che ha sviluppato l’intelligenza artificiale in un modo che permette di portare avanti certe richieste. Quindi, come sempre, non c’è nessuno che tutela le donne".

@analystnews Elon Musk received huge backlash for allowing sexually explicit images of women and children to be created on his social media platform, X, via its AI assistant, Grok. He responded by making it a premium feature. Now he’s banned it – but the ban doesn’t go far enough.

original sound - Analyst News

Nelle parole di Beatrice Petrella

È ancora sostenibile, dunque, parlare di neutralità tecnologica quando strumenti di IA producono in modo sistemico violenza simbolica, sessualizzazione e danni concreti ai diritti delle persone?” Beatrice Petrella: "Ovviamente no, perché la tecnologia non è neutra ed è figlia di chi la programma. Ognuno ha i suoi bias e quindi, per forza, la tecnologia non è neutra, in particolare quando si parla di intelligenza artificiale generativa, come in questo caso". E dunque, quali tutele specifiche dovrebbero essere garantite per impedire l’uso dell’IA nella creazione di immagini sessualizzate non consensuali, soprattutto quando coinvolgono donne e minori? Petrella risponde: "Questo è il punto più dolente, perché se da un lato servono delle tutele, bisognerebbe anche creare sistemi di rilevamento e muoversi in questa direzione. Ci dovrebbero essere tutele legali, quindi la criminalizzazione specifica della creazione e distribuzione di deepfake sessualizzati non consensuali, con aggravanti quando si parla di minori. Ma poi si dovrebbe parlare anche di prevenzione, di educazione digitale e di educazione sessuo-affettiva che parli di consenso e rispetto. Lo vediamo su Grok, ma ovunque: anche sull’accoltellamento nella scuola di La Spezia. Questo è un ennesimo caso emblematico di una società che fa tutto tranne che gestire questa cosa".

@carahuntermla Many parents have contacted me this week very concerned about grok creating naked AI-generated images of children. I’ve made a simplified video of support that is available. If you or your child is the victim of revenge AI generated image-based abuse, you can get help: Revenge Porn Helpline (UK, 18+) 0345 6000 459 | help@revengepornhelpline.org.uk

Il parere di Martino Wong

Per approfondire ulteriormente abbiamo parlato anche con Martino Wong, esperto in intelligenza artificiale e policy tech, che ci aiuta a capire le implicazioni giuridiche e operative dei modelli di IA generativa. La prima domanda è: le attuali normative su privacy, consenso e tutela dell’immagine sono sufficienti ad affrontare fenomeni come i deepfake sessuali generati dall’IA, o serve un nuovo quadro giuridico dedicato? "Sicuramente qualcosa già c’è a livello normativo" spiega Wong. "Abbiamo un nuovo articolo in Italia sulla diffusione di deepfake e nel frattempo c’è la richiesta che i contenuti generati con IA siano contrassegnati. Vedo una difficoltà nel fatto che gli strumenti per generare queste immagini siano così liberi. Ad esempio, abbiamo già una norma contro la diffusione di immagini intime non consensuali, ma vediamo che continuano a circolare, come nel caso del blog su PHICA.eu Lo stesso vale anche per i deepfake. Dovrebbe essere fatto qualcosa ad hoc anche per il nudo in deepfake, che ad oggi è la forma prevalente".

La responsabilità delle aziende di AI generativa

E le aziende di AI generativa, come si muovono in questo panorama sempre in movimento? "Ad oggi le aziende di IA pubblicano dei report quando rilasciano un nuovo modello, le cosiddette model card, in cui si spiega come è fatto il modello. Vengono svolti test di red teaming, in cui l’azienda stessa prova a violare le regole del modello per migliorarne la sicurezza e l’aderenza alle policy. Se si va, per esempio, sul sito di Google, viene spiegato che sono stati fatti test per evitare determinate derive. Si potrebbe fare un passo in più in termini di trasparenza, chiedendo alle aziende maggiori dettagli sugli sforzi fatti e su come sono stati condotti. Sicuramente si potrebbero imporre divieti più stringenti sui prodotti rilasciati: per esempio, su Gemini molte cose non si possono fare, mentre su Grok sì. Il punto è che esistono anche tanti modelli gratuiti ed è difficile limitare un modello in modo preciso, dato che sono generalisti".

E poi aggiunge: "Oltre a questo, un altro aspetto su cui si dovrebbe intervenire meglio è la distribuzione: esistono tanti servizi online, meno visibili di Grok ma facilissimi da trovare, che fanno pubblicità sui social, a volte anche in modo relativamente esplicito, lasciando intendere chiaramente che l’app permette di “svestire” una persona partendo da una foto. Queste app si trovano anche sugli store. La facilità di avere un software che fa queste cose è aumentata vertiginosamente". Insomma, c'è bisogno di regolamentazione, anche preventiva. "Invece di intervenire dal punto di vista della generazione di immagini, quello che abbiamo visto a livello di mercato è che sono usciti, o sono stati fatti uscire, i modelli di generazione di immagini prima di avere sistemi in grado di contrassegnare in modo robusto che un’immagine è stata generata con AI. Ci sono alcuni sistemi che inseriscono un segnale, ma è facile da rimuovere. Ad oggi, Google ne ha uno abbastanza robusto, che si chiama SynthID, ma Google stessa lo ha pubblicato e implementato solo dopo aver fatto uscire il modello, cioè quando ormai la fretta era già stata fatta. Se vogliamo arrivare a soluzioni di prevenzione in generale, c’è tantissimo che si può fare dal punto di vista del monitoraggio della raccolta dati. Mi viene in mente, per esempio, la raccolta di dati di vario tipo, a seconda della situazione, per monitorare in quali casi un certo gruppo viene discriminato o svantaggiato".

Un tema generale, quello della raccolta dei dati

Questo, ovviamente, non è un tema esclusivo delle AI, ma è una questione molto generale. "Sappiamo che anche l’atto di raccogliere dati non è neutro, perché cambia tutto a seconda di quali dati vengono raccolti su un certo fenomeno, come vengono organizzati, cosa si valuta e cosa non si valuta. Un esempio è il lavoro di Donata Columbro sui dati dei femminicidi: parla di come oggi vengono contati e di quanto sarebbe necessario fare di più. In questo senso, l’AI può essere uno strumento utile se creata secondo i valori che vogliamo seguire, perché la forza di un sistema AI è la capacità di gestire grandi quantità di dati. Anche qui, ovviamente, è fondamentale costruire il sistema in modo sensato, trasparente e accessibile a persone, ricercatori, eccetera, con sistemi di controllo e bilanciamento tra il funzionamento del sistema, la trasparenza e l’applicazione concreta. Altrimenti, il tema può facilmente scivolare verso la sorveglianza e altre pratiche problematiche per certi movimenti".